"Robots.txt để làm gì?", "Cách tạo và sử dụng robots.txt như thế nào?" là những câu hỏi muôn thuở của các thế hệ SEOer. Robots.txt là điều bắt buộc mà mỗi website cần phải có để có thể hoạt động hiệu quả và tương thích với các công cụ tìm kiếm.

Hôm nay, dichvuseos sẽ cũng bạn tìm hiểu về loại này nhé!

Robots.txt là gì?

Robots.txt là một file giúp chúng ta có thể tương tác được với các con bọ tìm kiếm, nói cho chúng biết chúng ta muốn chúng làm gì với website của chúng ta và không được làm gì, đó là ý nghĩa và tác dụng của file robots.txt.

Thế giới SEO có 2 bên chính đó là: các công cụ tìm kiếm website và bên còn lại là những người chủ của website.

Các công cụ tìm kiếm website, để có dữ liệu trả về cho người dùng khi người ta tìm kiếm , chẳng hạn google. Khi bạn vào google gõ tìm: “dich vu seo” thì google sẽ trả về một dãy kết quả. Vậy google lấy những thông tin đó ở đâu ? Nó lấy thông qua các con robot tự động.

Vậy làm sao người chủ website biết khi nào những con robot đó đến wbsite mình lấy dữ liệu ? Lỡ họ không muốn nó lấy dữ liệu của họ thì làm sao đây ? Để giải quyết vấn đề này, thì file robots.txt ra đời, nó sẽ đóng vai trò là một người trung gian giữa các công cụ tìm kiếm web – những người chủ website.

Khi các con robot thu thập dữ liệu vào website của ta, đầu tiên là nó sẽ truy cập vào file có tên robots.txt trước tiên. Nó sẽ xem trong đó, phân tích các dòng lệnh mà người chủ web viết trong file này, để nó biết được, chủ web cho nó được phép làm gì với web và không được phép làm gì với web của họ.

Kiểm tra website có robots.txt hay chưa?

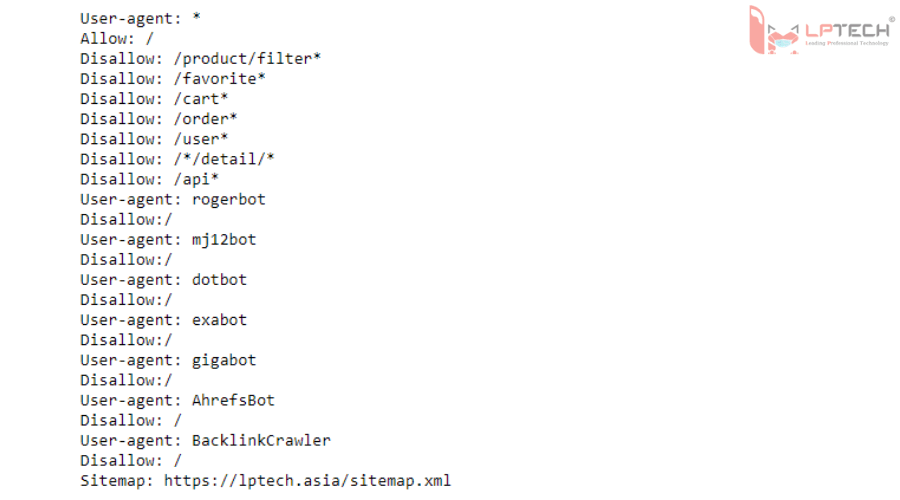

Nhập vào thanh tìm kiếm của Google: domainwebcuaban/robots.txt Ví dụ với trang dichvuseos.com này, tôi sẽ nhập: "https://www.dichvuseos.com/robots.txt" Sau đó Google sẽ trả về một trang .txt như hình bên phần dưới

Dưới đây sẽ là những hướng dẫn về cách đọc và hiểu về robots.txt

Hướng dẫn đọc file robots.txt

Ví dụ:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Chú giải :

- User-agent: * : cho phép tất cả các loại bot

- Disallow: /wp-admin/ : chặn thư mục wp-admin và tất cả những gì nằm trong thư mục wp-admin

Sử dụng file robots.txt là việc mà SEOer phải biết cách làm, Kiểm tra tình trạng website đã có robots.txt chưa, cho phép con bot của SE đi đến những nơi nào trên web,... là những gạch đầu dòng trên checklist công việc của SEOers.

Khóa toàn bộ website không cho bot đánh chỉ mục

User-agent: *

Disallow: /

Có nghĩa là cấm tất cả các loại bot truy cập vào tất cả tài nguyên có trên website của bạn, như vậy có nghĩa là website bạn chả thèm chơi với các SE.

Không cho phép bot truy cập vào thư mục nào mà mình không muốn

Lấy lại ví dụ trên :

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Điều này có nghĩa là cho phép tất cả các loại bot thu thập chỉ trừ 2 thư mục wp-admin và wp-includes

Chặn 1 trang

Disallow: /lien-he.html

Loại bỏ 1 hình từ Google Images

User-agent: Googlebot-Image

Disallow: /images/hinh.png

Chặn một bot nào đó

User-agent: SpamBot

Disallow: /

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

Để bắt đầu chỉ định mới thì bạn hãy đặt một dòng trắng. Và bot SpamBot bị cấm truy cập tất cả tài nguyên. Trong khi các bot khác được truy cập tất cả trừ thư mục “wp-admin ” và “wp-includes”.

User-agent: SpamBot

Disallow: /admin/

Disallow: /includes/

Disallow: /config/config.php

User-agent: *

Disallow: /admin/

Disallow: /includes/

Không cho phép SpamBot truy cập các thư mục được liệt kê như: thư mục “admin”, “includes” và và file “config.php” . Còn các bot khác được truy cập mọi thứ trừ hai thư mục “admin” và “includes”.

Sử dụng đồng thời “Allow” và “Disallow” cùng nhau

User-agent: Googlebot

Disallow: /vidu/

Allow: /vidu/demo-thoi-nha.html

Có nghĩa là chặn Googlebot truy cập vào tài nguyên có trong thư mục “vidu” .Nhưng chỉ có thể truy cập được file “demo-thoi-nha.html”.

User-agent: Googlebot

Disallow: /

User-agent: Googlebot-Mobile

Allow: /

Chặn không cho Googlebot truy cập vào tài nguyên trên website, nhưng lại cho phép Googlebot-Mobile truy cập vào tài nguyên trên website bạn.

Lưu ý thân thiện: khi các bạn sử dụng lại một robots.txt của ai đó hoặc tự mình tạo ra một robots.txt riêng cho website mình thì cần xem xét kỹ để tránh sai xót. Những lỗi thường gặp sau cần chú ý:

- Phân biệt chữ hoa chữ thường.

- Không được viết dư, thiếu khoảng trắng.

- Không nên chèn thêm bất kỳ ký tự nào khác ngoài các cú pháp lệnh.

- Mỗi một câu lệnh nên viết trên 1 dòng.

>> Xem thêm bài viết:

29/09/2020

29/09/2020